논문을 읽다보면 가끔씩 재밌는 제목을 보는 경우가 있습니다. 특히, 머신 러닝 분야에서 꽤 많이 볼 수 있는데요, 아마 사람들이 조금 생각이 자유롭고? 젊은...? 특성과 함께, 너무도 많은 논문들 속에서 내 걸 꼭 읽어라! 라는 심리가 같이 적용되어서 이런 현상이 생기지 않았나 싶습니다. 제가 발견한, 그리고 인터넷에서 사람들이 찾은 몇 가지 재미난 일화들?이나 논문들에 대한 얘기를 해보려고 합니다.

설명이 필요한 개그는 실패한 개그라지만... 한 번 둘러보겠습니다. (5번부터는 특별히 더 할 얘기는 없어서 논문 링크만 걸고 1234 번만 추가로 얘기했습니다)

- YOLO (You Only Look Once)논문과 그 저자 Joseph Redmon (저자도 참 특이합니다)

- GAN (Generative Adversarial Networks) 논문의 Acknowledgment에 있는 술집

- Attention is all you need

- Deep Paper Gestalt - 논문의 모양만 보고 논문의 수준을 판별해보자!

- We used Neural Networks to Detect Clickbaits: You won't believe what happened Next! (참고로 clickbait는 제목을 일부러 자극적으로 지어 클릭을 유도하는 것입니다, 그리고 연대 ai대학원 박노성 교수님이 쓰셨네요)

- Fixing a Broken ELBO (ELBO는 머신 러닝에서 꽤 쓰이는 개념인데 elbow로 개그쳤네요)

- Training on the test set? An analysis of Spampinato et al. [31] (제목에 다른 논문 인용을 하는 거의.. 유일한 논문)

- Cats and Dogs (고양이랑 개의 품종을 분류하는 태스크입니다 데이터셋도 공유했고요. 그냥 종 분류 vs 고양이랑 개 둘 중 하나로 맞추고 그것 내에서 종 분류를 비교하셨네요.)

- Optimal Brain Damage (Yann Le Cun이 90년대에 쓴 논문인데 최근 좀 하는 Neural Network pruning에 대해서 다루네요.)

- SAX series ; Experiencing SAX: a Novel Symbolic Representation of Time Series, HOT SAX: efficiently finding the most unusual time series subsequence, 등등.... (맨 처음 사이트가 Welcome to the SAX라는 홈페이지인데 이 시리즈들을 다 정리해 놓았네요. 색소폰 그림이 있긴 한데.. 아닙니다.)

1. You Only Look Once

Object Detection을 공부하면 꼭 배우는 YOLO 논문입니다. 기존 object detection은 이미지에서 물체가 있을 것 같은 region들을 찾고 그 이후 그 부분에 대해서 어떤 물체인지 classification을 하는 과정을 거칩니다. 이 논문에서는 region을 찾는 것과, classification을 동시에 할 수 있도록 만들어서 이미지를 딱 한 번만 보고 끝냅니다. 그래서 정확도는 조금.. 떨어질 수 있어도 무지하게 빠르죠. 저자인 Joseph Redmon의 발표도 들어보면 재밌습니다.

특히, real-time 데모를 (이 당시 그냥 노트북 하나 가지고 object detection을 데모하는 것은 쉽지 않았습니다. 연산도 큰데 제일 문제는 오래 걸려서 FPS가 얼마 안 나오거든요) 할 때 가끔 뒤에 벽 쪽에 toilet이었나 아무튼 이상한 결과들이 가끔 뜨는게 킬포입니다.

이 YOLO는 v2, v3, YOLO9000 등 여러 버전이 있는데, v3 논문이 정말 (가관)입니다.

참고로 v3 이후 v4 등 다른 논문은 이 분 논문이 아닙니다.

컴퓨터 비전 연구가 자꾸 군사와 개인 정보 등 여러 민감한 곳들을 건드리면서 이제 컴퓨터 비전 연구를 하지 않겠다고 했기 때문이죠. 사실 현재 뭐하고 있는지는 잘 모르겠습니다.

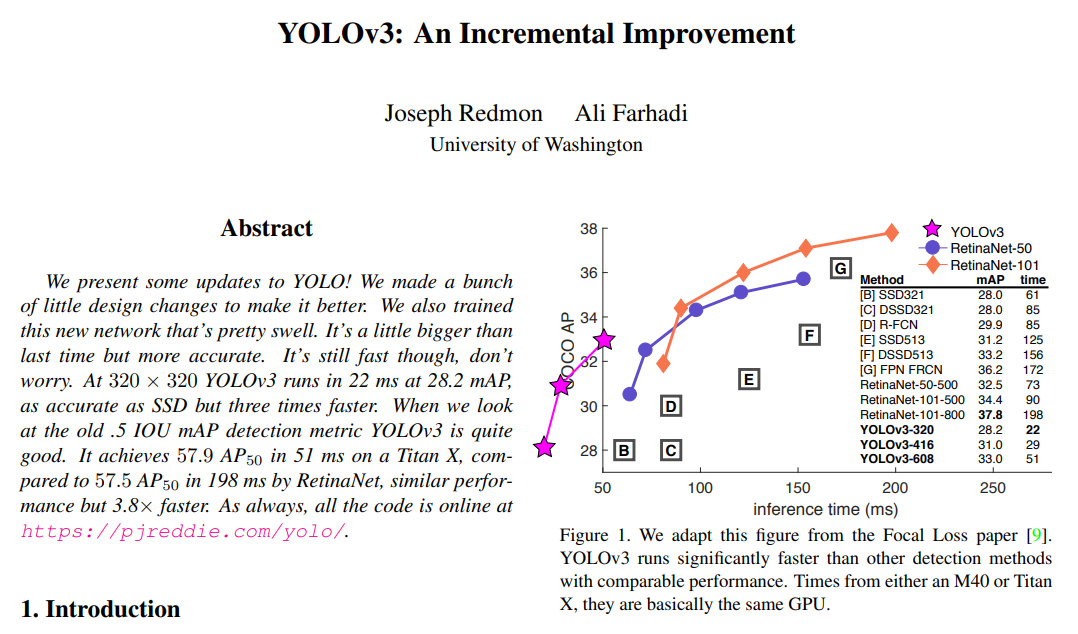

Yolo v3 논문은 다음과 같은데요, 전 pdf를 잘못 다운 받아서 그래프가 깨진 줄 알았습니다.

Figure 1부터 색깔이나 심볼이 독특하기도 한데, 처음보면 그래프가 깨진 것 같습니다. 도저히 상상도 못해본 그래프 방식인데, 자신감이 정말 넘쳐보입니다.

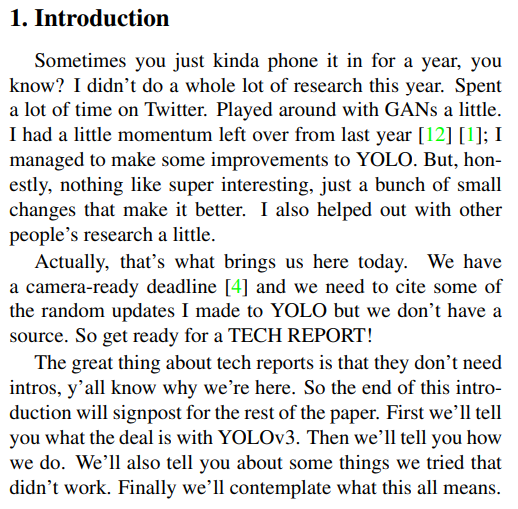

인트로를 읽어보면 정말 미친 것 같습니다..

살짝 번역을 해보자면,

가끔 그냥 1년 정도 폰만 볼 때 있잖아요? 전 이번 년도에는 별로 연구를 안 했습니다. 대부분의 시간을 트위터에서 보냈습니다. 조금 GAN 가지고 놀아보기도 하고요. 전 작년에 연구하던 관성이 조금은 남아 있어서(인용한 2개가 한 개는 뉴턴의 '자연철학의 수학적 원리'랑 하나는 '유추' 키워드의 Wikipedia...) YOLO를 조금 발전시켜보려고 했습니다. 하지만, 솔직히, 대단한 거 말고 몇 개 조금 바꾼 게 더 잘 되었습니다. 다른 사람들의 연구를 조금 도와주기도 했구요.

솔직히, 오늘 가져온 건 그게 답니다. 저희 지금 카메라 레디 제출 기한이 걸려 있고 YOLO를 바꾼 것들에 대해 인용을 달긴 해야하는데 지금 인용할 소스가 없습니다. 그러니까 일단 그냥 TECH REPORT처럼 가볼게요.

tech report의 좋은 점은 intro가 필요가 없다는 거고 이제 우리가 왜 이러고 있는지 알 거예요. 그래서 이 인트로 섹션의 끝이 논문의 시작이 되는 것이죠. 이 논문 앞 부분에서는 YOLOv3이 어떻게 되고 있는 것인지 말해드릴게요. 그리고 우리가 어떻게 했는지 말하고요. 그리고 해봤는데 안 된 것도 말해드릴게요. 마지막으로는 이것들이 무엇을 의미하는지 생각해봤습니다.

와 정말 소름이 끼칩니다. 그래도 마지막 부분에는 논문이 어떻게 흘러가는지에 대해서는 말해주네요.

이 분은 정말 탐색하면 탐색할수록 신기한 것들이 정말 많이 나옵니다. 사실 이 분에 대한 얘기는 분량이 너무 많이 차지할 것 같은데, 이 분 홈페이지는 꼭 들어가봐야합니다.

Survival Strategies for the Robot Rebellion

Welcome to my website! I am a graduate student advised by Ali Farhadi. I work on computer vision. I maintain the Darknet Neural Network Framework, a primer on tactics in Coq, occasionally work on research, and try to stay off twitter. Outside of computer s

pjreddie.com

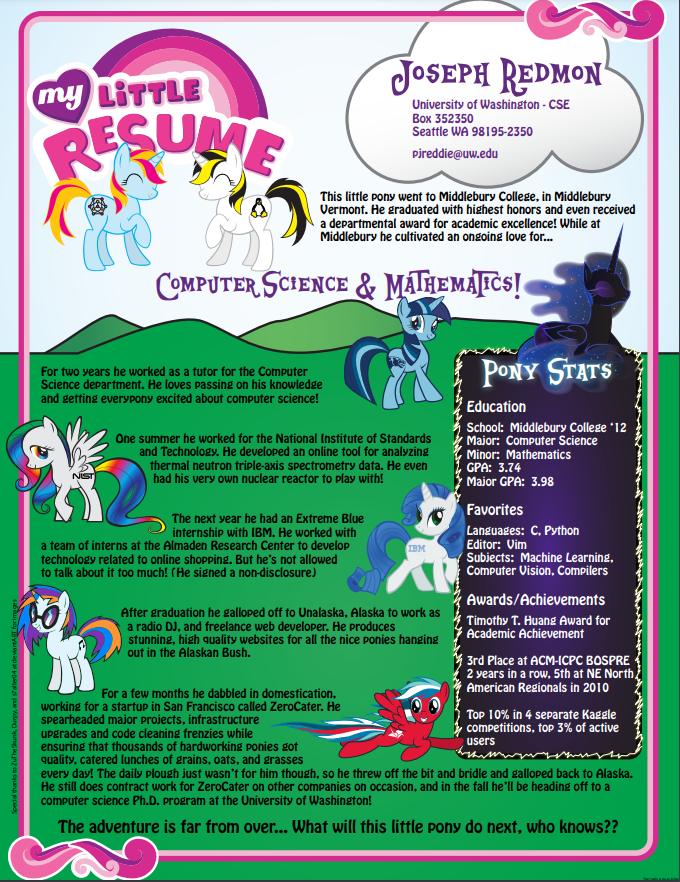

그 와중에 홈페이지 제목이 Survival Strategies for the Robot Rebellion (로봇 반란에서의 생존 전략) 이네요.... 진짜 미친 것 같습니다... 게다가 홈페이지에 들어가면 위에 있는 resume를 꼭 보셔야 합니다.

이 My Little Resume가 우리가 알고 있는 Resume라는 것이죠.. 사실 있을 게 다 있긴 합니다. 그런데 정말 정말 정말 흔히 볼 수는 없는 그런 CV죠. 홈페이지에 보면 다른 사람이 이 Joseph Redmon에 대해서 뭐라고 말하는지에 대한 것이 있는데,

일단 Daniel Scharstein 이라는 분('내 생각에 little pony 레주메는 아마 대학원 생활에서 좋은 선택은 아닌 것 같다')은 착한 분이시네요. 가까이 두셔야 할 분으로 보입니다.

아무튼 이것 말고도 저 분은 정말 재미난 분 같습니다. 사실 이런 짓을 해도 논문이 너무 대단하니까 아무도 뭐라 안 하는 것이겠죠. 역시 빨리 성공해야겠습니다.

2. Generative Adversarial Networks (GAN) 논문의 술집

Ian Goodfellow와 Yoshua Bengio 등이 작성한 GAN 논문에 대해서는 많이들 아실 것입니다. 이 GAN 논문은 정말 아이디어가 너무 대박인 논문인데요, 이러한 아이디어가 아마 술집에서 떠오른 것 같습니다.

논문의 하단인 Acknowledgments (감사의 글?) 에는 보통 어떤 과제나 지원이 있었는지를 작성합니다. 그런 지원들 덕분에 연구를 성공적으로 완성시켰으니 감사합니다 이것이죠. 그리고 같이 토론하거나 조금 도움을 준 (저자로 들어갈 정도는 아닌) 분들에 대한 감사도 표합니다. 그런데 여기 마지막 줄에 Les Trois Brasseurs 에서 저자들이 창의력을 발휘할 수 있도록 도와주었다는데 궁금해서 무엇인지 찾아봤습니다. '삼총사'라는 뜻은 있던데 어째 구글 지도로 찾아보니 음식점 이름 같더라고요.

그래서 조금 찾아보니 The GANfather이라는 인터뷰 기사가 있더라고요. 여기서 Les 3 Brasseurs라는 정체가 나옵니다. 역시 몬트리올에 있는 단골 술집이었다고 합니다.

저도 그래서 빨리 좀 괜찮은 논문 쓰고 제가 자주 가는 치킨집이 있는데 이름 넣으려고요.

3. Attention is all you need!

Attention은 원래 자연어처리 (NLP) 분야에서 많이 사용되던 방법인데 비전에서도 많이 사용되고 이제 거의 CNN 처럼 정말 백그라운드 지식처럼 널리 알려지게 되었습니다. 쉽게 정리해보자면 "어디에 집중할지"를 결정해서 그 부분에 대한 가중치를 더 주어 결정을 한다고 생각하면 편합니다. NLP에서 예를 들면 다음 문장에 빈칸이 있을 때 "나는 오늘 치킨을 ___ " 이를 채우려면 뭐 '나는 : 0.2', '오늘 : 0.4', '치킨을 : 0.8' 이런 식으로 값이 결정되고 '먹을거야' 이게 최종으로 결정된다 이런 식입니다. 비전과 같은 예시에서는 다음 그림처럼 어디 부분에 집중하는지가 나오고요.

이 Attention이 처음 등장한 것이 Attention is all you need 라는 논문입니다. 구글에서 작성했고요. 이후에 2가지 양상이 펼쳐집니다.

1. XXXXX is all you need 라는 짝퉁 제목들이 등장!

- Hopfield Networks is All you Need

- Torch.manual_seed(3407) is all you need (이건 대체 뭘까요..)

- Is Disentanglement all you need? (이제 묻기도 합니다)

- All you need is a good init, All you need is Color (All you need is XXXXX 도 나옵니다)

2. Attention is All You Need 를 조금 바꾼 Attention 논문들!

저 밑에 Explanation이 들어가는 두 논문은 장난이 아니라 꽤 읽어볼만한 논문들입니다. 사실 위에서 말로 설명했듯이 attention이 어디에 집중한다 이런 의미를 부여해서 또 Explainable AI 라는 분야에서 조금 연관성이 있습니다. Explainable AI라는 것은 AI 모델이 단순한 블랙 박스가 아니라 설명 가능해야 한다 라는 것에 집중하는 분야입니다. 그래서 AI 모델을 만들 때 어떻게 하면 사람이 알아들을 수 있는 형태로 결과가 나오느냐 혹은 그렇게 될 수 있도록 학습을 할 수 있느냐 등을 연구합니다.

그런데 사람들이 저 바로 위에 그림처럼 이미지 내에서 attention map을 보는 식으로, 혹은 NLP에서 attention value를 찍어봄으로써 단순히 explainability를 얻고자 하였는데 그러면 안된다 라는 논문이 있는 것이고, 또 not not 논문에서는 그게 아닌게 아니다 뭐 이런 내용입니다. 아직 사실 완벽하게 컨센서스가 합의된 부분은 아닌 것 같긴 합니다.

4. Deep Paper Gestalt

이 논문은 https://twitter.com/hardmaru/status/1075942918668529664 이 트위터 스레드를 보고서 발견한건데, 신기하고 웃겨서 소개해드립니다.

저자가 한 명인 논문인데, 약간 사이드 프로젝트처럼 그냥 재미 삼아 해본 것 같은 느낌이 있네요. 저도 나중에 저 혼자 저자인 논문을 써보고 싶기도 합니다.

이 논문에서는 CVPR 논문들을 가지고 논문 이미지만 가지고 accept이 될지 reject이 될지 classifier를 학습했다고 합니다. 그래서 50%의 reject된 논문들은 다 잘 reject하고 accept 되어야 할 논문의 0.4%만 reject을 주었다고 하니 학습은 뭐 어느 정도 된거네요.

여기서 이제 웃긴 점이 이 사람이 이렇게 프로젝트를 진행한 걸 가지고 논문을 쓴 다음에 자기가 학습한 분류기에 넣었더니 97%의 확률로 reject 당할 거라고 하네요 ㅋㅋ.

어쩌면, 저자가 한 명인 것이 조금 이상하게 보여서 reject을 줬을 수도 있겠다는 생각이 듭니다.

참 여러 랜덤한 주제들로 돌아보았는데, 이런 사소한 것들이 가끔 대학원 생활에서의 재미가 됩니다. 아마 공감하실 분들도 계시겠죠. 컴퓨터 비전, 머신 러닝 공부를 해보면서 정말 사람들이 재미 있는 것 같습니다. 머신 러닝과 생명 분야를 동시에 공부하니까 각각의 분야에 대해서 조금 차이점들을 볼 수 있었는데 확실히 저널 메인인 생명 분야 논문들에 비해서는 머신 러닝 분야에 조금 더 젊은 느낌이 납니다 ㅋㅋ..

혹여나 저널 논문을 메인으로 쓰시는 분이 이 포스트를 보셨다가 컴퓨터 분야 애들이 너무 촐싹대고 가벼운 느낌이라고 잘못 일반화를 하지 않으셨으면 좋겠습니다. 사실 여기에 있는 것들 제가 오래 찾아 모은 것이지 대부분 이렇지는 않거든요. 이 분야에서도 사실 점잖고 묵직한... 논문들도 엄청 많죠.

쓰면서 궁금해진 것인데, 한 번 바이오 분야, 혹은 네이쳐 계열 논문들에서 재미난 제목이나 스토리를 가진 논문들을 찾아봐도 좋을 것 같네요. 한 번 나중에 찾아보겠습니다.